Archiv

Neue Gedankenräume erobern.

Im Rahmen der Reihe "Luftfahrt der Zukunft" haben wir mit Dipl.-Ing. Malte Schwarze, der in Kooperation mit der RWTH Aachen zu neuen Verkehrsflugzeugen forscht, zu aktuellen Herausforderungen in diesem Bereich gesprochen. Im Interview verrät er, ob hybrid-elektrisch angetriebene Verkehrsflugzeuge umsetzbare Zukunftsvisionen sind oder reine Fiktion bleiben.

HDW: Was sind aus Ihrer Sicht die größten aktuellen Herausforderungen der Luftfahrt?

Malte Schwarze: Die Verkehrsluftfahrt ist weltweit nachhaltig im Wachstum, und das ist sicher gut so. Von technischer Seite besteht deshalb die zentrale Herausforderung, die eingegangenen Selbstverpflichtungen zur Reduktion von Emissionen, Treibstoffverbrauch und Lärm zu erfüllen. Hier hat man sich von Industrieseite mit der Vision 2020 und mit Flightpath 2050 absichtlich den Zielen verpflichtet, den Treibstoffverbrauch für neue Flugzeuge und den CO2 Ausstoß bis 2020 um 50% und bis 2050 um 75% zu senken. Die heutzutage besten erhältlichen strahlgetriebenen Flugzeuge auf der Kurz- und Mittelstrecke schaffen gerade einmal eine absolute Verbesserung im Treibstoffverbrauch von etwas über 20%. Heutige Verkehrsflugzeuge sind zudem laut - besonders in der Außenwahrnehmung. Man wollte hier den wahrnehmbaren Lärm im Flughafenbereich halbieren. Anders gesagt, die Herausforderungen sind klar und es gibt recht viel zu tun. Aber man hat bisher wenige Ideen, wie man diese herausfordernden Ziele in der Gesamtheit wirklich erreichen kann.

Aus gesellschaftlicher, sozialer und organisatorischer Sicht besteht die Hauptherausforderung darin, in den alten organisatorischen Strukturen Neues zu schaffen.

HDW: Welche Rolle können aus Ihrer Sicht dabei hybrid-elektrisch angetriebene Verkehrsflugzeuge spielen?

Malte Schwarze: Hybrid-elektrisch angetriebene Flugzeuge haben ihre Vorteile in der Allgemeinen Luftfahrt bereits in der Praxis eindrucksvoll demonstriert.

Der E-Genius, ein wahlweise voll-batteriebetriebenes oder hybrid-elektrisch betreibbares Flugzeug, das an der Universität Stuttgart entworfen und gebaut wurde, ist vor knapp drei Jahren mit zwei Personen von dort nach Italien über die Alpen geflogen – an einem Tag hin und zurück, und das vollelektrisch. Die Treibstoffkosten, wobei man hier ja gar nicht von Treibstoffkosten sprechen kann, haben für beide Personen 21 € für Hin- und Rückflug ausgemacht. Das schaffen Sie mit dem Billigflieger ab Stuttgart nur für eine Wegstrecke und nur für eine Person, und das weder unter Berücksichtigung der notwendigen Steuern noch im Fluge komplett emissionslos. Ein gutes Argument, um auch bei Airlinern wenigstens hybrid-elektrische Antriebssysteme zu entwerfen und zu integrieren. Diese haben auch in der Verkehrsluftfahrt das nachhaltige Potential, die Reise nennenswert wirtschaftlicher und damit auch umweltfreundlicher zu gestalten.

HDW: Wo liegen derzeit die größten Herausforderungen für hybrid-elektrische Antriebe bei Verkehrsflugzeugen? Wie können Lösungen aussehen?

Malte Schwarze: Sobald man elektrische Energie mit an Bord nimmt - sei es bei elektrischen oder bei hybrid-elektrischen Flugzeugen - kommt es vor Allem darauf an, diese möglichst effizient in wirksame Vortriebsleistung für das Flugzeug umzuwandeln. Dafür bedarf es mindestens zweier unabhängig rotierender vortriebserzeugender Flächen, die als Propulsoren die Schuberzeugung wirksam und effizient auch bei einer hohen Reisefluggeschwindigkeit von Ma 0,8, das sind rund 875 km/h in einer Höhe von 9000m, zuverlässig vollziehen können.

Diese große vortriebserzeugende Fläche an bestehenden Flugzeugkonfigurationen, die heute verbreitet unterwegs sind, zu integrieren, klappt in dieser Form nicht. Man muss sich also Gedanken machen, wie Flugzeug und Triebwerk auf neue Weise integrativ zusammenkommen.

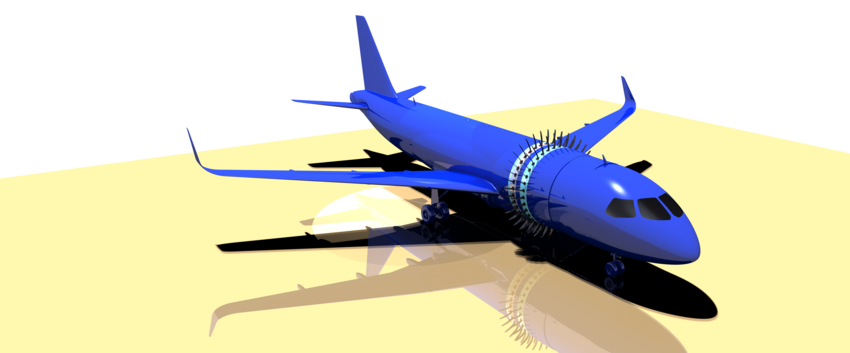

Eine aussichtsreiche Möglichkeit, diese große vortriebserzeugende Fläche am Flugzeug zu integrieren, besteht bei Kurz- und Mittelstreckenverkehrsflugzeugen dabei darin, diese in zwei Einheiten gegenseitig rotierend und hintereinander gestaffelt um den Rumpf herum auszuführen. Damit entfallen die widerstandswirksamen Triebwerksgondeln heutiger Flugzeuge. Das hat im Sinne eines hohen Vortriebswirkungsgrades noch weitere Vorteile. Die Rotoren beeinflussen sich durch ihre Staffelung in Reihe hinsichtlich ihrer Effizienz vorteilhaft. Die Rumpfgrenzschicht wird bei der Vortriebserzeugung mit eingesaugt, was die Effizienz ebenfalls maßgeblich steigert. Am Rumpfheck ist zudem eine bessere Druckrückgewinnung über den Rumpf wirksam, was den Schub vorteilhaft erhöht.

Durch ringförmige Elektromotoren kann vor dem Hintergrund der großen vortriebswirksamen Fläche die Drehumlaufgeschwindigkeit der Propulsoren im Direktantrieb, d.h. ohne Getriebe, so weit herabgesetzt werden, dass selbst in der Interaktion beider entgegengesetzt drehender Rotoren beim Start überhaupt keine überkritische Geschwindigkeit mehr erreicht werden kann. Das senkt den Lärm, selbst in Bezug zu heutigen Verkehrsflugzeugen, erheblich. Triebwerk und Rumpf kommen somit in einer integrativen Weise neu zusammen. Der Rumpf, der ja an sich für die Nutzlastunterbringung vorhanden ist, wird damit - so gesehen - zur Triebwerksgondel.

Die elektrische Antriebsleistung zum Vortrieb wird an Bord durch effiziente Wellenleitungsturbinen gewonnen, die direkt auf Generatoren einer speziellen Architektur einkoppeln. Durch den verfügbaren Platz der im Rumpf befindlichen Wellenleistungsturbinen ist es einfacher möglich, die Triebwerke thermodynamisch rekuperativ aufzuladen, was ihren inneren Wirkungsgrad und damit die Gesamteffizienz des Flugzeuges steigert.

Insgesamt könnten Lösungen für hybrid-elektrische Flugzeuge auf der Langstrecke, Kurzstrecke und im Regionalflugzeugbereich durchaus individuell verschieden aussehen.

Dabei kann eine hybrid-elektrische Antriebsstruktur allein nicht alle Herausforderungen bewerkstelligen. Vielmehr sind Beiträge aus den unterschiedlichsten Fachbereichen aus Aerodynamik, Struktur, Thermodynamik, Systemen und Leichtbau in einem Entwurf interdisziplinär zu integrieren, um einer hybridelektrischen Antriebsarchitektur dabei den richtigen Rahmen zu geben.

Weitere Verbesserungen sind hinsichtlich der Aerodynamik interessant. Fuselets wirken ähnlich wie Winglets, sitzen jedoch am Rumpf und wirken durch Erzeugung einer Schubkomponente gleichfalls widerstandsvermindernd und effizienzsteigernd.

Auch im Bereich des Leichtbaus sind Fortschritte auf zukünftige Flugzeuge zu übertragen, um das zusätzliche Gewicht, das mit dem elektrischen Antriebssystem in Verbindung steht, zumindest teilweise kompensieren zu können.

Ein wirklich optimiertes Verkehrsflugzeug bedeutet, dass alle Fachdisziplinen wie Struktur, Aerodynamik, Thermodynamik, Systeme und Flugzeugentwurf integrativ zusammen kommen.

In einer Zusammenschau liegt das Potential durch hybrid-elektrische Antriebsarchitekturen an einem interdisziplinär wirklich auf Effizienz optimierten Verkehrsflugzeug damit bei Treibstoffeinsparungen von 30%, und wahrscheinlich sogar mehr.

HDW: Blick nach vorne: Was glauben Sie, welche Rolle werden hybrid-elektrische Verkehrsflugzeuge im Luftverkehr in 10/20 Jahren spielen?

Malte Schwarze: Die Zeitspanne, die es erfahrungsgemäß braucht, um ein neues konventionelles Verkehrsflugzeug zu entwerfen, zu konstruieren, zu erproben und auf den Markt zu bringen, dauert etwa 10 Jahre. Bei einer neuen Antriebsarchitektur, z.B. einer hybrid-elektrischen Antriebsarchitektur, zu der derzeit im Verkehrsflugzeugbereich noch wenige Praxiserfahrungen bestehen, sollte man etwas mehr Zeit einplanen. Wenn man klug ist, fängt man also jetzt direkt damit an.

•

Zur Person: Dipl.-Ing. Malte Schwarze studierte Luft- und Raumfahrttechnik und Psychologie und forscht in Zusammenarbeit mit der RWTH Aachen an besonders effizienten und leisen Verkehrsflugzeugen.

•

Zur Reihe Luftfahrt der Zukunft

Luftfahrt der Zukunft widmet sich seit 2011 in Form von Vorträgen und Exkursionen den Entwicklungen im Bereich der Luftfahrt sowie neuesten Anwendungen und Lösungen der Luftfahrtforschung. Die Deutsche Gesellschaft für Luft- und Raumfahrt (DGLR), das Deutsche Zentrum für Luft- und Raumfahrt (DLR), das Niedersächsische Forschungszentrum für Luftfahrt (NFL) und der Verein Deutscher Ingenieure (VDI) präsentieren gemeinsam mit der Haus der Wissenschaft Braunschweig GmbH monatlich renommierte Expertinnen und Experten, die den heutigen Stand von Forschung und Technik in der Luftfahrt erläutern. Im Anschluss an die Vorträge können Fragen an die Referentinnen und Referenten gestellt werden. Diskussionen sind dabei stets willkommen.

Bild zum Beitrag:

Gegenseitig rotierend und hintereinander gestaffelte, um den Rumpf herumgeführte Propulsoren. (c) Bild, Illustration und Konzept Malte Schwarze.

Angst vor Strahlung ist weit verbreitet. Und tatsächlich – unsere Welt ist durchdrungen von ihr. Es gibt natürliche Strahlung – UV-Strahlung beispielsweise ist ein Bestandteil des Sonnenlichts, die kosmische Hintergrundstrahlung durchdringt das gesamte Universum und natürlich vorkommende radioaktive Strahlung in niedriger Dosis ist ein Nebenprodukt von Zerfallsprozessen gewisser Elemente.

Aber immer mehr Technologie in unserem modernen Leben hat uns zahlreiche weitere Strahlenquellen beschert. Die größten Ängste verursacht gesundheitsschädliche radioaktive Strahlung, die beispielsweise nach Katastrophen wie Tschernobyl und Fukushima in gefährlichen Ausmaßen freigeworden ist. Es gibt weitere Strahlungsquellen, die uns im alltäglichen Leben umgeben: Hochspannungsmasten, Radio- und TV-Signale, Mikrowellenherde, Funktelefone sind seit einigen Jahrzehnten präsent, nach dem Siegeszug von Mobilfunk und mobilem Internet sind es auch noch Abertausende Mobilfunkantennen, die landesweit einen permanenten Zugang zu mobiler Telefonie und Internet garantieren. All diese Strahlungsquellen werden häufig umgangssprachlich als „Elektrosmog“ bezeichnet. Unter Smog versteht man normalerweise Schadstoffpartikel in der Luft, der Vergleich ist physikalisch betrachtet unkorrekt, weil es keine „Strahlungspartikel“ in Luft gibt. Dennoch bleibt die Frage, ob Elektrosmog genauso gesundheitsschädlich ist wie Abgassmog.

Zunächst: Strahlung ist nicht gleich Strahlung, entscheidend ist, wie energiereich sie ist. Hochenergetische Strahlung bewirkt Effekte auf lebendes Gewebe. Sehr energiereiche Strahlung wie beispielsweise radioaktive Strahlung ist in der Lage, in die Zellen eines Körpers einzudringen und dort Elektronen aus den Atomen herauszuschlagen. Die Folge ist eine massive Schädigung des lebenden Gewebes. Experten sprechen in diesem Fall von „ionisierender“ Strahlung. Weitere Beispiele für ionisierende Strahlen sind UV-Strahlung oder Röntgenstrahlen.

Die elektromagnetischen Felder des Mobilfunks gehören zum Bereich der sogenannten nicht ionisierenden Strahlung. Ebenso WLAN, Radio- und Mikrowellen. Ihre Energie reicht nicht aus, um Elektronen aus Atomen oder Molekülen herauszuschlagen. Doch heißt das auch, dass Mobilfunk und Co. wirklich ungefährlich sind? Dies wird seit Jahren in vielen Studien untersucht. Und genau diese Frage wollen wir uns in unserer Diskussionsrunde „LTE, WLAN, Elektrosmog – wieviel Strahlung ist zuviel?“ widmen. Die geladenen Experten werden zu gängigen Fragen Stellung nehmen: Ist Telefonieren mit dem Smartphone am Ohr gefährlich? Muss man Angst vor Mobilfunkantennen haben? Wie nah darf man an dem WLAN-Router sitzen?

Matthias Hampe ist Professor für Elektromagnetische Verträglichkeit und Hochfrequenztechnik an der Ostfalia in Wolfenbüttel. Er misst unter anderem die Stärke von Mobilfunksendern in ganz Deutschland und hat eine interaktive Karte mit Feldstärken erstellt. Dr. Gunde Ziegelberger vom Bundesamt für Strahlenschutz ist Leiterin der Arbeitsgruppe "Exposition, Wirkungen und Risiken durch elektrische, magnetische und elektromagnetische Felder“. Sie kennt die Studienlage zu der Debatte genau. Und Dr. Thomas Kleine-Ostmann von der Physikalisch-Technischen Bundesanstalt in Braunschweig ist dafür verantwortlich, dass Geräte die Strahlung überhaupt korrekt messen. Außerdem hat er auch die Wirkung verschiedener Strahlungsarten auf lebende Zellen untersucht.

Unser Arbeitsleben hat sich grundlegend geändert. Im Wirtschaftswunderland Deutschland der 50er Jahre war es üblich, bei einem Unternehmen jahrzehntelang angestellt zu sein, oft blieb die erste Anstellung im Leben zugleich auch die einzige. Die dauerhafte unbefristete Vollzeitbeschäftigung war damals die Normalität.

Das hat sich grundlegend geändert. Junge Menschen sind es gewohnt, ihren Job mittlerweile alle zwei Jahre zu wechseln. Ganz einfach, weil dauerhafte unbefristete Stellen seltener werden. Die vollständige Integration in die sozialen Sicherungssysteme und die dauerhafte Identifikation mit einem Unternehmen bröckeln. Seit den 80er Jahren hat die Politik den Arbeitsmarkt dereguliert und befristete Stellen, Leiharbeit, Minijobs und Scheinselbstständigkeit haben zugenommen. Spätestens seit den Hartz-Gesetzen in den 2000er-Jahren hat sich diese Entwicklung beschleunigt. Während 1991 nur 4,4 Millionen Menschen befristet, in Teilzeit, geringfügig oder als Leiharbeiter beschäftigt waren, erreichte deren Zahl im Jahr 2011 mit über acht Millionen ihren Höhepunkt - eine Zunahme von 81 Prozent.

Der Druck des Arbeitsmarktes auf den Arbeitnehmer nimmt zu, und damit der Stress. Am Arbeitsplatz selbst sind die Hauptstressfaktoren oft zu hohes Arbeitspensum, Termindruck, Arbeitsunterbrechungen, schlechte Personalführung und die Informationsflut. Insbesondere durch die Digitalisierung und Email-Kommunikation wird von vielen Arbeitnehmern heutzutage Dauerverfügbarkeit erwartet.

Das eine Berufstätigen-Extrem ist der Angestellte, der unter hoher Arbeitslast leidet, ständig um seinen Job bangt und sich die Sinnfrage stellt, inwieweit er sich in der Organisation selbst verwirklichen kann. Oder - das andere Extrem - er verwirklicht sich als einer von immer mehr Selbstständigen hierzulande, dafür trägt er jedoch ganz alleine die gesamte Last der Verantwortung für die finanzielle und soziale Absicherung, was nicht selten zu massiver Selbstausbeutung führt.

Das alles hat Folgen: In einer aktuellen repräsentativen Befragung der Techniker-Krankenkasse (TK-Studie 2013) geben 70 Prozent der befragten Erwerbstätigen an, manchmal oder häufig gestresst zu sein. Rund die Hälfte der Befragten ist der Meinung, dass der Job dafür die Ursache ist. Wird der Stress zum Dauerzustand, kann er in Erschöpfungszustände münden: Burnout, Depression. Seit 1994 haben die Arbeitsunfähigkeits-Tage wegen psychischer Erkrankungen um 91 Prozent zugenommen - das ist nahezu eine Verdoppelung. Psychische Belastungen sind inzwischen Ursache Nummer eins für Frühverrentungen, die im Schnitt mit 48,3 Jahren erfolgt. Bereits jeder fünfte Arbeitnehmer leidet unter gesundheitlichen Stressfolgen - von Schlafstörungen bis zum Herzinfarkt.

Wir wollen diskutieren, wie Arbeitgeber unter den veränderten Rahmenbedingungen gute Arbeitsbedingungen schaffen und wie Arbeitnehmer Leistung und Wohlbefinden miteinander in Einklang bringen können. Unsere Gäste an diesem Abend bringen dabei verschiedene Perspektiven auf das Thema ein: Dietrich von der Oelsnitz ist Professor für Organisation und Führung an der Technischen Universität Braunschweig. Er leitet dort das Institut für Unternehmensführung, und erforscht, wie Firmen Arbeitsprozesse den Umgang mit ihren Angestellten verbessern können. Christine Müller ist eine von vier GeschäftsführerInnen und Gründerinnen der Gärtner Datensysteme GmbH & Co. KG, Braunschweig, ein Internetprovider für Unternehmen. Ihren Idealismus, sagt Frau Müller, habe sie sich bewahrt. In ihrem Betrieb läuft einiges anders. Karin Leven ist Organisationsberaterin und Coach - sie kennt die Belange und Wünsche von Arbeitgebern und -Nehmern und berät beide Seiten.

Einer aber blieb diese Belege nicht schuldig: Der neuseeländische Bildungsforscher John Hattie, Professor für Erziehungswissenschaften und Direktor des Melbourne Education Research Institute an der University of Melbourne (Australien), analysierte über viele Jahre hinweg Hunderte von wissenschaftlichen Studien aus der Unterrichtsforschung, bei denen insgesamt 250 Millionen Schüler beteiligt waren. In seiner Meta-Analyse wertete Hattie schließlich unterschiedlichste Unterrichtskonzepte hinsichtlich ihres Lernerfolgs aus – und erhielt am Ende eine Art Best-Practice-Anleitung für guten Unterricht. Dabei kamen einige überraschende Erkenntnisse zutage, die alten Überzeugungen und lange Zeit Geglaubtem widersprachen, dieses Mal jedoch fußend auf wissenschaftlich-empirischer Evidenz.

Zentrale Erkenntnis der Hattie-Studie: Die Arbeitsweise und die Persönlichkeit des Lehrers sind einer der wichtigsten Faktoren für den Lernerfolg. Entscheidend ist, dass der Lehrer sich immer wieder Feedback bei den Schülern einholt und den Lernerfolg überprüft. Weitere Erkenntnisse: Lehrergeleiteter Unterricht wirkte sich positiver auf Lernerfolg aus als offenere Lernformen, Gruppenarbeit und jahrgangsübergreifender Unterricht. Besonders überraschend: Kleinere Klassen und bessere finanzielle Ausstattung der Schule hatte kaum Auswirkungen auf den Lernerfolg.

Wir diskutieren bei unserer Veranstaltung „Schule – besser als ihr Ruf?“ mit den beiden Schulleiterinnen Ursula Hellert, Ilona Gerhardy-Grotjan, dem Bildungsforscher Marcus Friedrich und dem Bildungspolitiker Christoph Bratmann über die Erkenntnisse der Hattie-Studie, ihrer Umsetzung in den Schulen und den noch zu bewältigenden Problemen und Herausforderungen dabei. Diskutieren Sie gerne mit! Im Anschluss an die einstündige Podiumsdiskussion am 28. September 2017 stehen alle ReferentInnen und Referenten wie immer Ihren Fragen Rede und Antwort.

Wachsende Städte, der Klimawandel, sich ändernde Lebens- und Arbeitsformen und neue Technologien beeinflussen unsere Mobilität. Der motorisierte Individualverkehr, der derzeit noch alles dominiert, überfordert die Infrastruktur, insbesondere in der Stadt und macht sich als Stau und Parkplatznot bemerkbar. Hohe Feinstaubbelastung und CO2-Emissionen überfordern zudem Gesundheit und Umwelt. Gefragt sind neue Mobilitätskonzepte, die den drohenden Verkehrskollaps verhindern und zudem nachhaltiger sind.

Mobilitätsforscher erhoffen sich durch die Digitalisierung eine Verkehrswende. Sie wollen dadurch verschiedene Verkehrssysteme intelligent miteinander vernetzen. So sollen Smartphone-Apps künftig für Reisende aus Bus, Bahn, Auto und Fahrrad eine optimale Mobilitätskette errechnen, die sie von A nach B bringt - ohne Stau, ohne Anschlusslöcher, ohne Tarifdschungel.

Zusätzlich arbeiten Wissenschaftler daran, den Individualverkehr zu automatisieren: Autos sollen selbst fahren, damit Reisende die Zeit im Auto für andere Tätigkeiten nutzen können, beispielsweise um zu arbeiten oder zu lesen. Auch autonome Busse sind denkbar, die per App bestellt werden können und ihre Fahrgäste einsammeln - auf der für alle optimalen Route. Vernetzt man die Autos und Busse zudem, kann man künftig darüber auch Staus vermeiden. Und wenn doch mal Stau ist, steigt man spontan in den nächsten Zug - eine App mit aktuellen Infos aller Verkehrsträger kennt den besten Weg.

Diese Entwicklung könnte unser Verhältnis zum eigenen Auto grundlegend ändern. Wenn man jederzeit Zugriff auf automatisiertes Carsharing hat, benötigt man womöglich gar kein eigenes Auto mehr. Jedenfalls im Ballungsraum Stadt. Anders aber stellt sich die Situation auf dem Land dar, wo der öffentliche Verkehr noch große Lücken aufweist und man noch kaum auf das eigene Auto verzichten kann.

Der Verkehr der Zukunft wirft zudem viele Fragen auf: Wie versteht sich ein automatisiertes Auto mit einem herkömmlichen? Wie kompliziert wird Mobilität durch die Digitalisierung - werden ältere Menschen ausgeschlossen? Wie sicher sind vernetzte, autonome Autos gegenüber Hackerangriffen? Und wie gläsern werden Bürger, wenn man jede ihrer Bewegungen in einem digitalisierten Verkehrsnetz künftig erfassen kann?

Antibiotika waren eine der größten Erfindungen des letzten Jahrhunderts, sie nahmen bakteriellen Infektionskrankheiten wie Cholera, Tuberkulose, Syphillis den Schrecken. Aber die Evolution schläft nicht, die Bakterien haben nachgerüstet und Resistenzen gegen auch die stärksten Antibiotika entwickelt. Die Ursachen dafür sind vielfältig. Einer der Hauptgründe ist der häufig noch zu leichtfertige und oft auch falsche Einsatz von Antibiotika. Ärzte verschreiben diese Präparate immer noch zu häufig und viele Patienten wissen immer noch nicht, dass Antibiotika nur gegen Bakterien und nicht gegen Viren wirken. Auch der Einsatz von Antibiotika in der Tiermast produziert zusätzlich resistente Keime.

Die alten Waffen werden zunehmend stumpf und es kommen zuwenig neue hinzu. Der Grund: Für die Pharmakonzerne ist es nicht lukrativ genug, neue Antibiotika zu entwickeln. Ein neuer Wirkstoff wird häufig als Reserve zurückgestellt und spielt für den Konzern kaum Geld ein. Die Weltgesundheitsorganisation WHO warnte daher bereits vor einem "post-antibiotischen Zeitalter": Im 21. Jahrhundert könnten "verbreitete Infekte und harmlose Verletzungen wieder tödlich sein".

Vor allem in Krankenhäusern machen sich resistente Keime bemerkbar. Ohnehin schon geschwächte Patienten können sich dort mit multiresistenten Erregern wie MRSA und ESBL infizieren, was tödlich enden kann. Genaue Zahlen hat niemand, weil es schwierig ist zu belegen, ob ein resistenter Erreger die Todesursache war oder nur eine Begleiterscheinung - aber die Bundesregierung spricht von rund 15.000 von multiresistenten Erregern verursachten Todesfällen pro Jahr in Deutschland. Sie hat einen Zehn-Punkte-Plan entwickelt, um das Problem einzudämmen. Zentral ist dabei die Einhaltung strengerer Hygienemaßnahmen in den Krankenhäusern und einer besseren Überwachung der Antibiotika-Verordnungen und ihres Einsatzes in der Tiermast. Viele Maßnahmen sind erforderlich, um das Problem in den Griff zu kriegen - nicht nur auf nationaler Ebene, denn resistente Erreger kümmern sich nicht um Grenzen. Besonders dramatisch ist die Lage in Schwellenländern.

Mit unseren Gästen diskutieren wir das Problem in all seinen Facetten: Chefarzt Wilfried Bautsch berichtet von der Lage in der Klinik. Die Tierärztin Kristina Kadlec vom Friedrich-Löffler Institut erläutert, warum Antibiotika in der Tiermast problematisch sind. Mark Brönstrup vom Helmholtz-Zentrum für Infektionsforschung entwickelt neue Wirkstoffe und berichtet, warum es so lange dauert, bis wir neue Antibiotika haben. Und der Gesundheitspolitiker Christos Pantazis erklärt, was die Politik gegen die sich ausbreitenden Resistenzen tun kann.

Dieses Jahr stehen in Frankreich und in Deutschland Wahlen an – ausgerechnet zu einer Zeit, wo es noch nie so leicht war, Menschen mit gezielten Unwahrheiten zu beeinflussen. Propaganda und Fake News verbreiten sich über Social-Media-Kanäle wie Twitter und Facebook rasant, oftmals werden sie gar nicht mehr von echten Menschen in die Welt gesetzt, sondern von sogenannten Social Bots, Computerprogrammen, die in sozialen Netzwerken vorgeben, reale Nutzer zu sein und auf diesen Kanälen Meinung im Sinne ihrer Erschaffer beeinflussen sollen.

Besonders deutlich wurde das bei der Brexit-Diskussion und dem letzten US-Wahlkampf, wo Social Bots bereits zum Einsatz kamen. So ermittelten Forscher, dass nur rund 60 Prozent der Follower von Donald Trump und Hillary Clinton echte Menschen waren – der Rest waren Computerprogramme. Ihr Ziel: Den politischen Gegner diskreditieren, Masse erzeugen, um eine Meinung zu verstärken, Statistiken verdrehen, Stimmungen erzeugen, Menschen verunsichern – oft mithilfe von Lügen und kompromittierendem Material aus Cyberangriffen.

Die Unterschiede zwischen den Bots sind sehr groß. Im einfachsten Fall beschränkt sich das selbständige Handeln dieser Roboter darauf, vorgefertigte Nachrichten zu versenden. Komplexere Bots sind aber auch in der Lage, mit echten Nutzern zu interagieren und eigenständig neue Texte zu generieren. Da die normale Kommunikation in den sozialen Netzwerken in der Regel nicht besonders komplex ist, fallen aber auch die primitiven Bots häufig nicht auf.

Es existiert bereits eine regelrechte Schattenwirtschaft. Man kann Bots auf dunklen Kanälen kaufen, die auf Twitter und Facebook und in den Kommentarspalten von Online-Medien automatisch Texte verbreiten. Über einfache Schnittstellen kann man so viele Bots auf einmal steuern und sie leicht mit Textbausteinen versorgen, die verbreitet werden sollen.

Eine große Mehrheit der Menschen in Deutschland ist davon überzeugt, dass von Social Bots und Fake News eine reale Gefahr ausgeht. Bei einer aktuellen repräsentativen Umfrage des Meinungsforschungsinstituts YouGov stimmten 44 Prozent der Aussage „voll und ganz“ und 40 Prozent „eher“ zu, dass Fake News die Wahlen beeinflussen können. Nur 9 Prozent waren der Meinung, dass Fake News „eher nicht“, oder „ganz und gar nicht“ (2 Prozent) Einfluss haben auf die Bundestagswahlen. Dass Populisten aufgrund von Fake News an Zustimmung gewinnen, glauben 40 Prozent „voll und ganz“, 37 Prozent „eher“ (10 Prozent „eher nicht“, 4 Prozent „ganz und gar nicht“).

Inwieweit und ob überhaupt Social Bots tatsächlich Auswirkungen auf die öffentliche Meinung haben, darüber gibt es noch keine gesicherten wissenschaftlichen Erkenntnisse. Das Büro für Technikfolgenabschätzung ist eine wissenschaftliche Einrichtung zur Beratung des Bundestags. Es lässt seit Oktober 2016 die gesellschaftliche und politische Relevanz von Social Bots untersuchen.

Medienforscher vermuten, dass der Einfluss von Bots eher indirekt sein könnte, indem sie Journalisten und Politikern Meinungstrends vorgaukeln, die diese wiederum in ihrer Berichterstattung oder ihrer Politik beeinflussen. Aber sie können laut Medienforschern vermutlich die Gesellschaft polarisieren, Spannungen verstärken und Risse zwischen gesellschaftlichen Gruppen verstärken.

Ansgar Kellner ist Informatiker am Institut für Systemsicherheit der TU Braunschweig. Er beschäftigt sich mit der Erkennung von Social Bots und ist an einem BMBF-geförderten Projekt namens „Propstop“ beteiligt. Das Ziel: Social Bots erkennen und ausschalten. „Viele Bots verraten sich durch bestimmte Merkmale “, sagt Kellner. Programme, die ununterbrochen, auch nachts, Meldungen senden, seien simpel zu erkennen. „Manche aber simulieren Nacht-Wach-Zyklen, um so realistischer zu wirken.“ Er hofft, am Ende einmal ein System zu haben, das letztlich mit einer gewissen Wahrscheinlichkeit angeben kann, ob es sich um einen Bot handelt oder nicht. Dieses System könnte Moderatoren von Diskussionsforen dabei unterstützen, Propaganda-Bots herauszufischen und zu sperren.

Das Problem: Social Bots sind nicht verboten, es gibt keinerlei Regulierung durch den Gesetzgeber. Immerhin haben die deutschen Parteien verkündet, im Wahlkampf keine Propaganda-Roboter einsetzen zu wollen, um mit Fake News Verwirrung zu stiften. Doch das bleibt freiwillig. Die Grünen haben eine Anmeldepflicht für Social Bots gefordert. Die Unionsfraktion brachte eine Kennzeichnungspflicht ins Spiel.

Nach Meinung von Harald Rau braucht es jedoch keine „Fake-News-Polizei“. „Was wir brauchen ist mehr Medienkompetenz und selbstbewusstere Medien“, sagt Rau.

Erschwert wird die Debatte dadurch, dass selbst hochrangige Politiker wie US-Präsident Donald Trump Falschmeldungen verbreiten und ihrerseits die Medien als Verbreiter von Fake News bezichtigen. Dies erzeugt zusätzlich ein Klima der Unsicherheit.

Der Siegeszug des Erdöls begann vor etwa 150 Jahren – zunächst löste es in Form von Petroleum das Walöl als Brennstoff für Lampen ab. Und sehr schnell wurde es der Treibstoff der jungen, boomenden Automobilindustrie – das ist bis heute seine Hauptrolle. Aber wir verfeuern Erdöl nicht nur, es ist auch einer der wichtigsten Rohstoffe der Industrie. Ein Großteil der Produkte des modernen Lebens basieren auf dem Schwarzen Gold: Kunststoff, Textilien, Medikamente, Bau- und Dämmstoffe, Verpackungen, Putzmittel, Kosmetika. Erdöl aber ist eine endliche Ressource – und eine, die den Klimawandel befördert. Daher müssen wir Alternativen finden.

Die Wirtschaft soll sich erneuern, soll weg von fossilen, hin zu erneuerbaren Rohstoffen – so der Wille der Bundesregierung. Künftig könnten beispielsweise die Autoreifen aus Löwenzahn-Gummi hergestellt werden, der Kunststoff aus Kaffeesatz, und Essensbestandteile aus Algen. Nur drei Beispiele für das Ziel, künftig alle Produkte des modernen Lebens nach und nach aus Pflanzen, Mikroorganismen und Algen zu erzeugen. Außerdem soll dadurch auch die weltweite Ernährung langfristig gesichert werden und das Ungleichgewicht zwischen ressourcenreichen und –armen Ländern beendet werden.

Jörg Overmann, Geschäftsführer der Deutschen Sammlung von Mikroorganismen und Zellkulturen, sieht vor allem im Einsatz von Bakterien enormes Potenzial: „Bakterien bieten eine enorme Artenvielfalt, die wir zum größten Teil noch gar nicht kennen.“ Die entdeckten wie noch unentdeckten Einzeller stellen einen genetischen Schatz für die Biotechnologie dar, der neuartige Fertigungsprozesse möglich machen wird.

Die Umstellung auf nachwachsende Rohstoffe ist eine gewaltige Aufgabe, bei der auch Fehler passieren können. Im Bereich Energie hat in der jüngeren Vergangenheit ein Zuviel an politischer Förderung dazu geführt, dass Bauern vermehrt Mais zur Biogas-Erzeugung angebaut haben. Dadurch kam es zur Konkurrenz von Nahrungs- und Energieerzeugung. Den richtigen Weg zu finden, ist schwierig, wie Folkhard Isermeyer, Chef des Thünen-Instituts betont. Um ihn zu finden, hat das Bundesforschungsministerium 2009 den sogenannten Bioökonomierat eingesetzt, ein Expertengremium aus Wissenschaftlern, Biotechnologen und Ökonomen. Der Rat soll Strategien für die Umstellung der Wirtschaft entwickeln und seine Erkenntnisse auch für die Öffentlichkeit aufbereitet.

Die Politik muss dann die Weichen stellen, fordert Martina Kolarek, Referentin für Bioökonomie beim Naturschutzbund. Das tut sie vor allem durch Forschungsförderung und direkte Förderung gewünschter Prozesse und Produkte. Kolarek, die sich schon lange mit dem Thema beschäftigt, bezweifelt jedoch, dass eine Umstellung der derzeitigen Wirtschaft auf natürliche Rohstoffe eins zu eins gelingen kann. „Letztlich kommen dann die Rohstoffe aus dem Boden. Bei dem derzeitigen Ressourcenbedarf werden wir wieder Nutzungskonflikte haben und wir laufen Gefahr, die Böden zu überfordern“, sagt Kolarek. Und am Ende muss diese biobasierte Wirtschaft auch konkurrenzfähig sein – und zwar in einer globalisierten Welt.

„Es nützt nichts, Strafsteuern auf fossile Rohstoffe zu erheben“, sagt Folkhard Isermeyer. Damit würde man nur energieintensive Industrien aus dem Land drängen, die diese Produkte im Ausland produzieren und „wir würden sie wieder importieren“, so Isermeyer. „Wir brauchen daher ein international abgestimmtes und leicht kontrollierbares Vorgehen.“

Der Abschied vom Erdöl ist eine gewaltige Aufgabe, die auch die Mithilfe jedes Einzelnen erfordert. Denn es ist fraglich, ob wir einfach so weiter machen können, wie bisher, glaubt Martina Kolarek.

CO2 einsparen bedeutet, weniger fossile Brennstoffe zur Stromerzeugung benutzen. Aber Sonne und Wind lassen sich nicht so steuern wie ein Kohlekraftwerk. Wenn Deutschland einmal vollständig mit Strom aus Sonnen- und Windkraft versorgt werden soll, muss man den Strombedarf genau kennen, um ihn flexibel erzeugen zu können. Dafür braucht man "intelligente Stromnetze", Smart Grids, deren Einführung die EU bereits vor einigen Jahren beschlossen hat. Doch intelligente Netze brauchen "intelligente Stromzähler" (Smart Meter). Sie messen permanent den Stromverbrauch eines Haushalts und melden an den Energieversorger zurück.

Auch Deutschland setzt den EU-Beschluss nun um und beginnt 2017 schrittweise mit der Einführung von Smart Metern. Als erste sollen Großverbraucher mit einem Jahresverbrauch von mehr als 10.000 Kilowattstunden Smart Meter einbauen, ebenso Bürger mit einer Photovoltaik-Anlage. Ab 2020 werden Smart Meter dann auch für private Haushalte verpflichtend, zunächst auch nur für große Haushalte mit einem Jahresverbrauch von mehr als 6000 Kilowattstunden (entspricht einer monatlichen Stromrechnung von 145 Euro). Nach und nach sollen dann alle Haushalte die Smart Meter einbauen.

Nicht nur das Klima soll davon profitieren, sondern auch der einzelne Verbraucher - so jedenfalls das Versprechen der Befürworter der Geräte. Smart Meter sollen mehr Transparenz über den eigenen Verbrauch schaffen, Kunden können sehr bequem per App ihren Verbrauch jederzeit im Blick behalten. Auch flexible und auf den persönlichen Verbrauch abgestimmte Stromtarife sollen so möglich werden - und womöglich günstiger sein als die bisherigen. Weiterer Effekt der intelligenten Stromzähler: Sie können zur Steuerungszentrale des intelligenten Hauses werden, Waschmaschine und Heizung ließen sich zeit- und fernsteuern.

Aber erst einmal kosten die Smart Meter. Zwar hat der Gesetzgeber die Betriebskosten der Smart Meter auf maximal 100 Euro pro Privathaushalt gedeckelt. Das aber allein bedeutet schon eine Steigerung zu herkömmlichen Stromzählern, die nur 30 Euro im Betrieb kosten. Und fraglich ist, ob ihre Einsparpotenziale die Kosten der Geräte aufwiegen. Kritiker bezweifeln das.

Kritiker sorgen sich zudem um den Datenschutz. Zwar hat das BSI hohe Anforderungen an die Geräte gestellt, was Datenschutz und -Sicherheit angeht. Trotzdem gibt es Sorgen ind er Bevölkerung durch diese Geräte zum gläsernen Bürger zu werden. Aus den Verbrauchsprofilen lassen sich nämlich Verhaltensprofile ablesen, ob jemand zuhause ist oder nicht, wann und wie oft er welche Geräte benutzt. Zudem garantiert die Datenverschlüsselung nur die sichere Übertragung der Daten vom Smart Meter zum Energieversorger. Wünscht der Kunde aber, dass seine Daten für eine App-Steuerung aufbereitet werden, landen sie im normalen Internet.